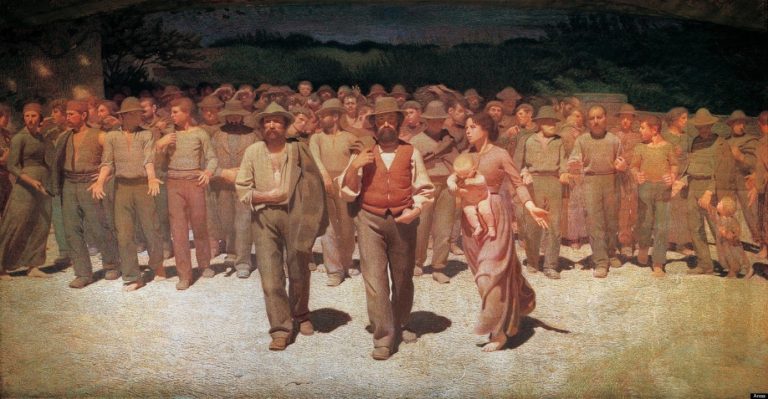

Come nell’opera simbolo delle lotte operaie del Novecento, oggi un nuovo “quarto stato” avanza: è composto da annotatori, moderatori, micro-lavoratori digitali. Invisibili, ma indispensabili all’AI.

Ogni modello di intelligenza artificiale – da ChatGPT ai sistemi di riconoscimento facciale, fino alla guida autonoma – nasce e si perfeziona solo grazie a una massiccia quantità di dati che devono essere annotati, puliti, categorizzati. In una parola: etichettati.

Questo processo, chiamato data labeling, è ciò che permette al modello di “imparare”. Ma a etichettare i dati non sono i computer, bensì milioni di lavoratori umani, distribuiti nei Paesi del Sud del mondo, assunti tramite piattaforme come Amazon Mechanical Turk, Appen, Sama, Scale AI.

Nel 2023, Time Magazine ha rivelato che OpenAI ha incaricato lavoratori kenioti di filtrare contenuti violenti e razzisti per addestrare ChatGPT, pagandoli tra 1,32 e 2 dollari l’ora[1]. Questo significa che, prima di parlare con noi in tono educato, il modello ha “visto” e “imparato” cosa non deve dire grazie a esseri umani che hanno assorbito quei contenuti, spesso traumatici, al suo posto.

Il partner di outsourcing di OpenAI in Kenya era Sama, un’azienda con sede a San Francisco che impiega personale in Kenya, Uganda e India per etichettare i dati per clienti della Silicon Valley come Google, Meta e Microsoft. Sama si promuove come un’azienda di “intelligenza artificiale etica” e afferma di aver contribuito a far uscire dalla povertà oltre 50.000 persone.

Nel suo celebre studio sul “Ghost Work”, l’antropologa Mary L. Gray e l’informatico Siddharth Suri collaborano per svelare come i servizi forniti da aziende come Amazon, Google, Microsoft e Uber possano funzionare senza intoppi solo grazie al giudizio e all’esperienza di una vasta e invisibile forza lavoro umana. Mary L. Gray descrive questi lavoratori come una “nuova classe globale di operai digitali invisibili“[2] che eseguono micro-task dietro un’interfaccia, senza sapere per chi lavorano.

Le piattaforme – Appen, Clickworker, Lionbridge – fungono da intermediari: garantiscono l’anonimato ai committenti, ma scaricano sui lavoratori la pressione della competizione, del rating, dell’instabilità. Non c’è contratto, non c’è previdenza. Chi sbaglia viene penalizzato da un algoritmo.

Secondo l’Oxford Internet Institute, ci sono oltre 20 milioni di digital laborers impegnati in questi compiti a livello globale. Il 60% lavora in Africa e Sud-Est asiatico, in Paesi dove il salario medio locale rende anche un dollaro all’ora “competitivo”[3].

[1] Billy Perrigo, “Exclusive: OpenAI Used Kenyan Workers on Less Than $2 Per Hour to Make ChatGPT Less Toxic”, TIME, 18 gennaio 2023. Link

[2] Mary L. Gray, Siddharth Suri, Ghost Work: How to Stop Silicon Valley from Building a New Global Underclass, Houghton Mifflin Harcourt, 2019.

[3] Mark Graham et al., The Fairwork Cloudwork Ratings 2022, Oxford Internet Institute, University of Oxford.

Le aziende Big Tech celebrano il potere dell’AI nel ridurre i costi del lavoro e aumentare l’efficienza. Ma non ammettono che il loro prodotto dipende tuttora dal lavoro umano sottopagato. Una forma moderna di “estrattivismo cognitivo”, dove i dati e il tempo degli altri diventano carburante per l’innovazione.

Lo dimostra la corsa ai modelli multimodali (capaci di elaborare testo, immagini, suono): richiedono milioni di annotazioni manuali. Annotazioni che nessuna AI è ancora in grado di produrre con la precisione richiesta. La promessa dell’autonomia totale rimane, per ora, retorica.

Oggi esistono standard per misurare i bias dei modelli, la loro sicurezza, l’impatto ambientale dell’AI. Ma non esiste uno standard per calcolare l’impronta sociale dell’intelligenza artificiale.

Nel Stanford AI Index Report 2024, non esiste una singola sezione dedicata ai diritti dei lavoratori che producono dati[1]. I costi umani dell’AI vengono ignorati perché si trovano a monte del ciclo di vita dell’algoritmo.

Eppure, la domanda centrale è: possiamo davvero chiamarla “intelligenza” se si fonda sullo sfruttamento?

L’Unione Europea, con l’AI Act approvato in via definitiva nel 2024, ha fatto un primo passo importante, ma parziale. La normativa si concentra prevalentemente sulla classificazione dei rischi legati all’uso dell’AI, lasciando in ombra il lavoro umano nei processi di addestramento e manutenzione dei modelli.

Tuttavia, un emendamento approvato dal Parlamento Europeo nell’aprile 2023 ha inserito l’obbligo per le aziende che sviluppano sistemi ad alto rischio di documentare “l’impiego di risorse umane nella fase di training e supervisione algoritmica”. Una forma timida di trasparenza, ma ancora lontana da una tutela strutturale.

Alcuni Paesi stanno andando oltre:

Le organizzazioni mondiali, invece, come l’ILO (International Labour Organization) ha pubblicato nel 2021 il report “The Role of Digital Labour Platforms in Transforming the World of Work”, che denuncia apertamente le condizioni lavorative spesso abusive nel digital labor, auspicando l’introduzione di standard globali sui diritti minimi.

Anche l’UNESCO ha adottato la Recommendation on the Ethics of Artificial Intelligence nel 2021, un documento guida che invita gli Stati a garantire giustizia redistributiva e inclusione sociale nei processi legati all’AI.

[1] Stanford Institute for Human-Centered Artificial Intelligence, AI Index Report 2024, Stanford University, marzo 2024.

Dietro ogni forma di AI c’è una forma di lavoro umano. Invisibile, ma essenziale. Finché non riconosceremo questa verità, continueremo a costruire un’AI che non è né etica, né sostenibile.

Se davvero vogliamo un’intelligenza artificiale al servizio dell’umanità, dobbiamo iniziare da chi la costruisce.

Sede Legale e Operativa:

Via Gaggiolo, 27 – 6855 Stabio (CH)